Deep fake: Simulacija koja briše granicu između stvarnosti i iluzije

Zbog straha da bi ta ista tehnologija mogla da se iskoristi kao sredstvo za moguće manipulisanje tokom američkih izbora – zabranjena je upotreba takozvanog deep fake-a na društvenim mrežama.Podijeli

PrintWASHINGTON —

Oživjela princeza Leja, podmlađeni Robert De Niro – kompjuterski su generisane iluzije koje ovih dana oduševljavaju publiku u bioskopima. Međutim, zbog straha da bi ta ista tehnologija mogla da se iskoristi kao sredstvo za moguće manipulisanje tokom američkih izbora – zabranjena je upotreba takozvanog dipfejka na društvenim mrežama. Istovremeno, razvijaju se i programi za otkrivanje lažnih snimaka.

“Ulazimo u eru kada naši neprijatelji mogu da učine da izgleda kao da bilo ko govori bilo šta u bilo kom trenutku”, poruka je koju 2018. američki glumac Džordan Pil saopštio javnosti simulirajući bivšeg američkog predsjednika Baraka Obamu. Od tada se granica između stvarnog i lažnog dodatno istanjila.

Simulacija koristi vještačku inteligenciju kako bi se iskombinovi različiti izvori slike i napravila ubjedljiva iluzija. Tehnologija koja se ubrzano razvija sada je dostupna skoro svima, a uskoro će moći da prevari i najopreznije gledaoce. To posebno izaziva zabrinutost u godini održavanja predsjedničkih izbora u Americi.

“Takozvani dipfejkovi omogućavaju zlonamjernim akterima da izazivaju haos, podjele ili krize, i mogu da poremete cijele kampanje, pa i predsjedničke”, bila je poruka zabrinutog Adama Šifa, predsjedavajućeg Odbora za obavještajna pitanja.

Kompanije za društvene medije objavile su brojna saopštenja, navodeći da će uklanjati dipfejkove čiji je cilj da se obmanu birači. Ali prvo – moraju da ih nađu. Digitalna trka je u toku – a cilj je da se stvore sredstva da se identifikuju dipfejkovi.

Hani Farid, stručnjak za digitalnu forenziku, zabrinut je da bi u završnim danima predsjedničke kampanje moglo da dođe do dipfejk napada.

“Možemo da, recimo, zamislimo da se 48 sati ili 24 sata pred izbore, ili pred primarne izbore, objavi video snimak na kojem se vidi da kandidat govori nešto što u stvarnosti nikada nije rekao – nešto uvrijedljivo ili nelegalno”, rekao je Farid.

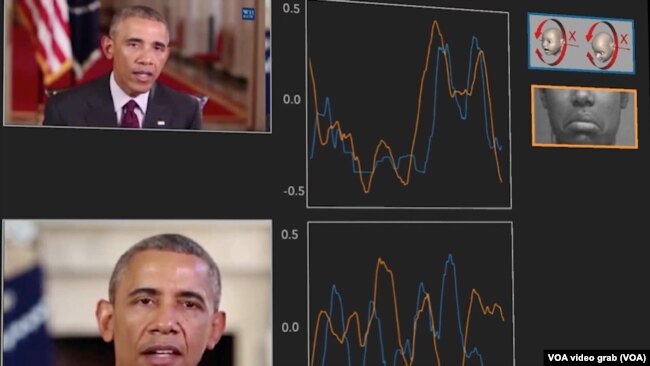

Faridov tim programira softver za vještačku inteligenciju da otkriva dipfejkove, tako što ubacuje sate video snimaka svakog predsjedničkog kandidata da bi kompjuter pronikao njihovu jedinstvenu gestikulaciju i govor.

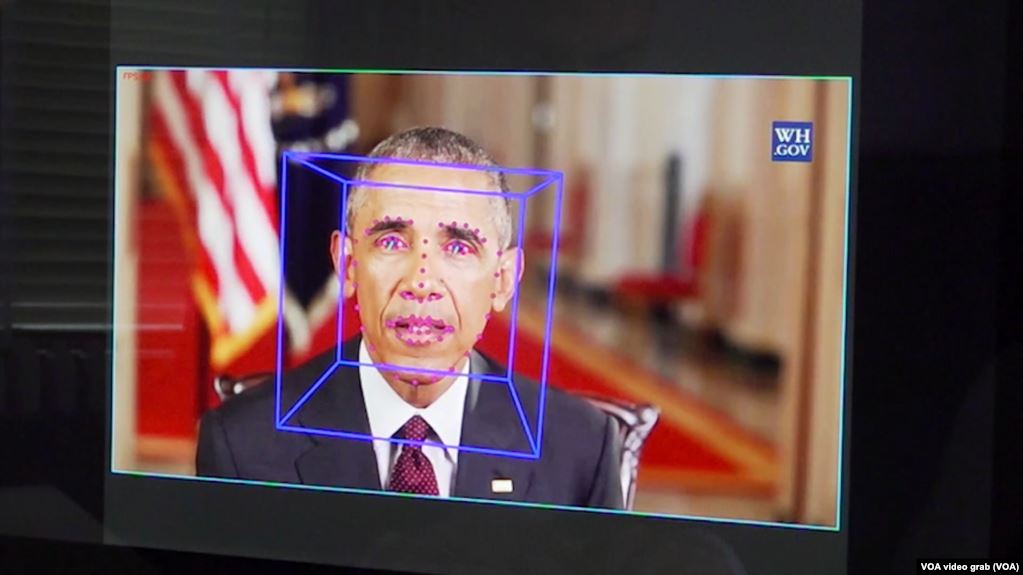

“Uzmemo video snimak i pratimo pokrete lica u nekom periodu. Plava kutija mi govori kako se glava kreće u trodimenzionalnom prostoru a zeleni laseri koji izlaze iz očiju govore nam u kom smjeru osoba gleda. Onda možemo da te podatke o pokretima lica upotrijebimo da bismo razlikovali dipfejk od autentičnog videa”, objašnjava Farid.

Ukazuje da je želja programera da novu tehnologiju ustupe novinarima kako bi mogli da utvrde autentičnost snimaka na kojima su prikazani političari.

Fondacija za vještačku inteligenciju, još jedna je organizacija, koja se pridružila borcima protiv ovakve vrste manipulacije. Ta kompanija kreira vještačke ličnosti koje procjenjuje korisnim za društvo – ali istovremeno čine dostupnim i sredstva za otkrivanje lažnih likova.

“Imamo model koji može da identifikuje dio snimka koji je lažiran. Želimo da prepoznamo potencijalnu štetu koju može da donese ova vrsta tehnologije koju stvaramo”, objašnjava Delip Rao, predstavnik fondacije

Pošto nijedan pristup ne može samostalno da otkrije svaki dipfejk, fondacija otvara platformu nazvanu Reality Defender – ili Branilac stvarnosti – koja kombinuje alatke za otkrivanje lažnih slika uzimajući ih od različitih istraživača tako da bi javnost mogla da je koristi.

“To će biti naš ‘Projekat Menhetn’ – da se borimo protiv dezinformaicja. On će zahtijevati da se udruže ljudi iz potpuno različitih oblasti”, kaže Rao.

Fesjbukova zabrana dipfejka i dalje dozvoljava takozvane čipfejkove, kao što je snimak Nensi Pelosi, predsedavajuće Predstavničkom domu, sa izmijenjenim govorom, koji je prošle godine masovno dijeljen na internetu. To, ukazuje Hani Farid, stručnjak za digitalnu forenziku, znači da korisnici digitalnih medija imaju važnu ulogu u zaustavljanju širenja dezinformacija.

“Vi, kao korisnik, morate da počnete da bolje prepoznajete i pravite razliku u sadržaju koji konzumirate i koji širite dalje”, kaže Farid.

Djeluje da će u budućnosti zaštita stvarnosti od neistine biti odgovornost zajednice.